Geneviève FIEUX-CASTAGNET et Gérald SANTUCCI

Octobre 2020

N.B. Les opinions exprimées dans cet article visent à susciter un débat ; elles n’engagent que leurs auteurs et ne reflètent pas nécessairement celles des organisations auxquelles ils appartiennent.

Données personnelles, vie privée, éthique : de quoi parlons-nous ?

« L’éthique, à la différence de la loi, est avant tout une affaire interpersonnelle ; elle ne saurait faire l’objet de règles générales sans prendre le chemin de la tartufferie. En face de toute interdiction, posons-nous une seule question : à qui telle action nuit-elle directement ? A personne d’autre qu’à son auteur ? Alors, laissons faire, laissons vivre. Au besoin, indignons-nous : il est d’autant plus légitime de condamner moralement ce que l’on aura eu le courage de tolérer légalement. »

Gaspard Koenig, philosophe et président du think tank GenerationLibre, Les Échos, 16/09/2020

« La force de la morale, c’est sa cohérence interne. C’est aussi sa faiblesse : à cause de sa systémisation, il y a le risque de mettre le réel entre parenthèses. Mais le risque de l’éthique n’est pas moindre : si elle n’est qu’une discussion indéfiniment ouverte sur le bien et le mal, elle finit par dissoudre ces notions dans le bavardage et de se faire, au final, la caisse d’enregistrement du pathos et de l’opinion. La morale a la dureté de la loi, mais l’éthique a la mollesse d’un dialogue infini. De nos jours, la morale est très connotée. On entend « moralisateur » derrière le mot « morale ». Un discours qui juge… »

Martin Steffens, « Éthique et morale, de quoi parle-t-on ? », Le Figaro, 28/09/2018

Un peu d’histoire…

Jamais auparavant dans l’histoire de l’humanité les questions de l’identification et de la surveillance des individus ne s’est posée avec autant d’acuité qu’aujourd’hui.

L’Europe a donné le la en 1995 avec la directive sur la protection des données, complétée en 2002 par une autre directive concernant le traitement des données à caractère personnel et la protection de la vie privée dans le secteur des communications électroniques (e-privacy).

Pour être plus complet, il convient de rappeler que c’est l’Allemagne qui a été le premier pays à porter son attention sur le respect de la vie privée (privacy). En fait, c’est la région de la Hesse qui, en 1970, a mis en place la première loi sur la protection des données[1], suivie bientôt par les autres Länder puis par le niveau fédéral[2]. En 1983, la cour constitutionnelle de l’Allemagne fédérale a établi que l’individu possède un droit constitutionnel à l’auto-détermination en matière d’information. Cette décision interdit le traitement des données personnelles sauf en cas d’autorisation statutaire spécifique ou de consentement de la personne concernée. En 1990, une nouvelle loi fédérale sur la protection des données a incorporé ces exigences constitutionnelles.

Avant le milieu du dix-huitième siècle, la question de la protection des données personnelles ne s’est quasiment jamais posée. Puis durant deux siècles, en raison de l’industrialisation et des cartes perforées, elle est devenue progressivement un thème de réflexion, quoique fort limité. Après 1945, ce thème s’est imposé dans le débat public avec l’arrivée des grands ordinateurs (à partir de 1945), des miniordinateurs (1975), des ordinateurs personnels (années 1980) puis des réseaux informatiques (années 1990). Cette accélération des changements dus aux technologies numériques s’est poursuivie avec l’augmentation continue de la puissance des systèmes informatiques, l’accroissement des largeurs de bande de transmission et des capacités de stockage des données, la réduction permanente de la taille des composants jusqu’à leur disparition du champ de vision, l’émergence de nouveaux concepts (biométrie, reconnaissance de la parole, géolocalisation, intelligence artificielle, blockchain, etc.) et l’apparition du traitement des données omniprésent (informatique diffuse, réseaux ubiquitaires, internet des objets, systèmes cyber-physiques, etc.).

Le « droit au respect de la vie privée » a été posé pour la première fois aux États-Unis par les juristes de Boston Samuel WARREN et Louis BRANDEIS[3] :

« Le fait que chacun doit avoir une protection complète tant de sa personne que de ses biens est un principe aussi vieux que la loi commune ; mais il a semblé nécessaire de le redéfinir périodiquement pour renouveler sa nature exacte et l’étendue d’une telle protection. Les changements politiques, sociaux et économiques entraînent la reconnaissance de nouveaux droits et la loi commune, dans son éternelle jeunesse, s’étoffe pour satisfaire les nouvelles demandes de la société (…) Plus tard s’est imposée une reconnaissance de la nature spirituelle de l’homme, de ses sentiments et de son intelligence. Peu à peu le champ de ces droits juridiques s’est étendu et aujourd’hui le droit à la vie signifie le droit à la jouissance de la vie, le droit d’être laissé tranquille. »

Ce « droit d’être laissé tranquille » constitue la première brèche juridique dans le vaste débat ultérieur sur le respect de la vie privée. Il ne s’agit à l’époque que d’un droit essentiellement physique, c’est-à-dire un droit à maintenir une certaine distance par rapport aux autres. Il s’inscrit dans l’idée américaine de la « poursuite du bonheur » qui figure dans la Déclaration d’indépendance du 4 juillet 1776 : « Nous tenons pour évidentes par elles-mêmes les vérités suivantes : tous les hommes sont créés égaux ; ils sont dotés par le Créateur de certains droits inaliénables ; parmi ces droits se trouvent la vie, la liberté et la recherche du bonheur. Les gouvernements sont établis parmi les hommes pour garantir ces droits, et leur juste pouvoir émane du consentement des gouvernés (…) ». L’avènement de l’informatique et l’explosion du numérique qui s’ensuivit ont évidemment bouleversé la conception du respect de la vie privée, provoquant des débats aussi passionnants qu’interminables et jusqu’à aujourd’hui inaboutis sur les données personnelles, la vie privée et l’éthique.

| Année | Pays | Titre |

| 1972 | Allemagne (Région de la Hesse) | Loi sur la protection des données |

| 1974 | États-Unis | Loi fédérale sur la protection des renseignements personnels |

| 1977 | Allemagne fédérale | Loi sur la protection des données |

| 1980 | OCDE | Lignes directrices sur la protection de la vie privée |

| 1981 | Conseil de l’Europe | Convention 108 pour la protection des données à caractère personnel |

| 1995 | Union Européenne | Directive 95/46/CE sur la protection des données |

| 2000 | Union Européenne | Protection des données à caractère personnel dans la Charte des droits fondamentaux de l’Union Européenne (Article 8) |

| 2002 | Union Européenne | Directive sur la vie privée et les communications électroniques (e-privacy) |

| 2005 (actualisation en 2015) | APEC (Coopération économique Asie-Pacifique) | Cadre de protection de la vie privée |

| 2016 | Union Européenne | Règlement général (UE) 2016/679 sur la protection des personnes physiques à l’égard du traitement des données à caractère personnel et à la libre circulation de ces données, et abrogeant la directive 95/46/CE |

Au tournant du 21ème siècle de nouveaux enjeux liés aux technologies numériques et à la « transformation » qu’elles entraînent sont apparus qui ont posé d’une façon nouvelle les questions de la protection des données personnelles, du respect de la vie privée et aussi de l’éthique.

Parmi ces technologies figurent en tête l’internet des objets, l’intelligence ambiante, la RFID (identification par radiofréquence) et la NFC (communication en champ proche), l’informatique affective, l’informatique en nuage, la bioélectronique, la neuroélectronique, l’intelligence artificielle, la symbiose homme-machine.

Prenons quelques exemples.

L’Internet des Objets (IdO), un concept ayant vu le jour en 1999, renvoie à l’idée d’objets qui « bavardent » entre eux et avec les humains. Les systèmes numériques se déploient partout (notion d’ubiquité) et ils sont invisibles en raison de la taille de plus en plus petite des microprocesseurs, des marqueurs RFID (identification par radiofréquence) et des autres dispositifs intégrés aux objets de tous les jours. Les menaces pour l’individu sont principalement :

- la somme des petites traces d’information qu’il laisse derrière lui du fait de ses activités quotidiennes (data shadows),

- le profilage comportemental, et

- la manipulation.

L’internet des objets ne désigne pas seulement le réseau informatique qui connecte des objets, il renvoie également au concept d’objet qui, comme l’a montré l’auteur de science-fiction Bruce Sterling[4], s’est métamorphosé au fil du temps. D’abord un artefact (i.e. un outil rudimentaire lié aux civilisations de chasse et d’agriculture), puis une machine (i.e. un objet complexe reposant sur une source d’énergie artificielle) et enfin un produit (i.e. un objet manufacturé et reproduit en un grand nombre d’exemplaires identiques), l’objet dans l’ère numérique peut être aussi un gizmo (i.e. un objet complexe, comme par exemple un logiciel, qu’il est plus difficile de simplifier que d’augmenter, qui requiert un apprentissage de la part de ses utilisateurs et qui s’appuie sur d’autres objets pour exister) ou un spime (i.e. un objet traçable, identifiable, localisable, muni de dispositifs numériques, par exemple des puces RFID, et existant en réseau). Si l’on se projette plus loin dans un futur indéterminé (autour de 2060, selon Sterling), avec notamment la convergence Nano-Bio-Info-Cogno (NBIC), l’objet deviendrait un biot, c’est-à-dire une entité qui serait à la fois un objet et un humain !

Les nanotechnologies opèrent à une échelle comprise entre 1 et 100 nanomètres (nm) et permettent de créer et utiliser des structures, composants et systèmes qui, du fait de leur petite taille, présentent des propriétés et fonctionnalités nouvelles que l’on cherche à transposer à l’échelle macroscopique afin d’en tirer parti. Ces technologies sont invisibles à l’œil nu, même en s’aidant d’une loupe, et elles permettent de capter des informations comme la température, la tension, la pression.

Ces avancées technologiques renvoient à l’image de la « poussière numérique », c’est-à-dire des particules à l’échelle moléculaire capables de tracer et suivre les individus, sans qu’ils en aient conscience, grâce à diverses mesures indépendantes dont les données sont transmises et reçues à travers les réseaux numériques.

Plus récemment, l’intelligence artificielle et la 5G sont venues compléter les technologies numériques déjà en déploiement.

Les données à caractère personnel

La notion de « données à caractère personnel » n’est pas aussi facile à caractériser qu’on pourrait le croire. Dans la directive 95/46/CE, sa définition est ainsi libellée :

« toute information concernant une personne physique identifiée ou identifiable (personne concernée) ; est réputée identifiable une personne qui peut être identifiée, directement ou indirectement, notamment par référence à un numéro d’identification ou à un ou plusieurs éléments spécifiques, propres à son identité́ physique, physiologique, psychique, économique, culturelle ou sociale ».

Le règlement général 2016/679 sur la protection des données a mis à jour cette définition en introduisant la notion d’« identifiant » qui complète la notion précédente de « numéro d’identification » et en ajoutant l’identité « génétique » aux éléments spécifiques susceptibles de permettre d’identifier une personne physique :

« toute information se rapportant à une personne physique identifiée ou identifiable (ci-après dénommée « personne concernée »); est réputée être une « personne physique identifiable » une personne physique qui peut être identifiée, directement ou indirectement, notamment par référence à un identifiant, tel qu’un nom, un numéro d’identification, des données de localisation, un identifiant en ligne, ou à un ou plusieurs éléments spécifiques propres à son identité́ physique, physiologique, génétique, psychique, économique, culturelle ou sociale. »

Dans un avis de 2007, le groupe de travail « Article 29 » sur la protection des données avait passé en revue et analysé les éléments constitutifs de cette définition[5] :

- « toute information »

- « concernant »

- « une personne physique »

- « identifiée ou identifiable »

Cet avis déjà ancien est toujours d’actualité pour préciser la définition de « données personnelles » dans le règlement de 2016.

Le constat général est que l’intention du législateur européen était d’adopter une notion large de données à caractère personnel afin d’assurer la protection des libertés et des droits fondamentaux des personnes physiques, notamment de la vie privée, à l’égard du traitement des données à caractère personnel. Un consensus s’est dégagé pour dire que le champ d’application des règles de protection des données ne devait pas être trop étendu mais en même temps qu’il fallait éviter de restreindre indûment l’interprétation du concept de données à caractère personnel. Les autorités de protection des données, telle la CNIL en France, « jouent un rôle essentiel pour parvenir à un équilibre approprié dans le champ d’application de la directive ».

Le respect de la vie privée

Si la notion de respect de la vie privée – les Anglo-saxons emploient le terme privacy – est ancienne[6], elle n’a pas fait l’objet jusqu’ici d’un large consensus sur son interprétation. Le respect de la vie privée est reconnu comme un droit humain fondamental dans la Déclaration universelle des droits de l’homme (article 12), le Pacte international relatif aux droits civils et politiques (articles 14 et 17) et dans beaucoup d’autres conventions internationales et régionales concernant les droits humains. Il conforte notamment les valeurs de dignité humaine, de liberté d’association et de liberté de parole. La nomination par le Conseil des droits de l’homme en juillet 2015 du premier Rapporteur spécial sur le droit à la vie privée[7] reflète l’importance croissante de ce droit dans les politiques planétaires concernant le numérique.

La sophistication croissante des technologies de l’information et des communications, avec notamment la possibilité offerte de collecter, analyser et diffuser des données à caractère personnel, s’est traduite par un besoin de législation dans de nombreux pays. Au cours des trente dernières années, le niveau des informations générées par chaque individu a atteint des sommets en raison des avancées en matière de santé, télécommunications, systèmes de transports et transferts financiers. Les ordinateurs, reliés à des réseaux à large bande, génèrent des dossiers sur chaque personne physique sans qu’il soit nécessaire de disposer d’un système informatique central unique.

Il n’est pas aisé de distinguer les notions de « respect de la vie privée » et de « protection des données à caractère personnel ». Selon les situations, l’une peut être perçue comme englobant l’autre. Les juristes s’accordent toutefois pour dire que la « protection des données » renvoie au mécanisme juridique destiné à assurer le « respect de la vie privée ». Le terme anglo-saxon privacy désigne le droit de tout citoyen de contrôler ses informations personnelles et de décider de l’usage qu’il en fera (c’est-à-dire de les révéler ou pas). Les spécialistes de ces questions considèrent le plus souvent que le terme privacy peut se rapporter aux éléments suivants[8] :

- les données personnelles

- les communications personnelles

- la personne physique

- le comportement de la personne

- la localisation et le lieu

- la pensée et les sentiments

- l’association et les groupes

Aux États-Unis, le concept de privacy prévaut tandis que dans l’Union Européenne c’est celui de « protection des données à caractère personnel » qui s’impose. Il convient de noter que le règlement général sur la protection des données ne fournit pas de définition de la « vie privée », pas plus que l’ancienne directive de 1995. Ainsi, par exemple, aux États-Unis on parlera d’analyse d’impact sur la vie privée (Privacy Impact Assessment – PIA – selon la traduction anglaise) tandis qu’en Europe on préfèrera utiliser la locution analyse d’impact sur la protection des données (Data Protection Impact Assessment – DPAI) qui est l’une des notions les plus importantes du règlement général européen sur la protection des données. Les conceptions américaine et européenne s’opposent en ce que l’Europe privilégie un cadre législatif global tandis que les États-Unis développent des règlements concernant le respect de la vie privée pour chaque secteur de l’économie, comme par exemple pour les services financiers (le Gramm-Leach-Bliley Act), la vie privée des enfants sur Internet (le Children’s Online Privacy Protection Act) ou encore le domaine médical (le Health Insurance Portability and Accountability Act).

Une autre différence importante entre les deux régions du monde porte sur l’autorité chargée de faire appliquer les règles : en Europe il s’agit des pouvoirs publics tandis qu’aux États-Unis ce sont les entreprises et les individus qui décident eux-mêmes, ce qui place ces derniers dans une position de faiblesse puisque la plupart du temps ils sont peu ou mal informés des conséquences des options offertes par le secteur privé en matière de respect de la vie privée. En 2016, la Commission européenne et les États-Unis s’étaient accordés sur un cadre juridique pour les transferts transatlantiques de données : le « bouclier vie privée UE-États-Unis » visant à protéger les droits fondamentaux des citoyens de l’Union lorsque leurs données sont transférées vers les États-Unis et à apporter une sécurité juridique aux entreprises[9]. Mais le 16 juillet 2020, la Cour de Justice de l’Union Européenne (CJUE) jugea que ce cadre ne protégeait pas suffisamment les données européennes et risquait donc d’entraîner des violations des droits des citoyens, conformément au règlement général sur la protection des données (RGPD). La CJUE estima que la législation américaine sur l’accès aux données personnelles transférées depuis l’UE et l’utilisation de celles-ci par les autorités publiques du pays « n’est pas limitée de manière à satisfaire des exigences essentiellement équivalentes à celles requises par le droit communautaire ».

L’arrêt de la CJUE est évidemment une mauvaise nouvelle pour les entreprises, qui préfèrent toujours disposer de mécanismes fiables et stables pour envoyer des données de l’Union Européenne vers les États-Unis. Il crée un obstacle au commerce électronique entre l’Union Européenne et les États-Unis, à un moment où les relations commerciales mondiales sont de plus en plus tendues. En revanche, il constitue une victoire pour les partisans de la protection de la vie privée qui avaient fait valoir à juste titre que le bouclier de protection ne couvrait pas suffisamment les données européennes.

L’éthique

L’éthique a surgi dans le débat public et sur l’agenda politique des autorités publiques à travers le monde lorsque l’Internet des Objets et l’intelligence artificielle se sont déployés dans quasiment tous les recoins de l’économie et de la société. L’éthique soulève une question plus large que celle de protection des données personnelles ou celle de respect de la vie privée, même si elle englobe ces dernières.

Valeurs et vie privée

Le mot n’est pas nouveau : le grec Aristote en a précisé les contours dans son « Éthique à Nicomaque »[10] avant que de nombreux auteurs, de Spinoza à Wittgenstein, n’apportent leur pierre à l’édifice. Si l’on laisse de côté l’univers aristotélicien et ses « vertus » (par exemple, le courage, la tempérance, la générosité, la grandeur d’âme, l’orgueil, l’ambition saine, la douceur, la véracité, l’humour, la gentillesse, la justesse), la conception d’un système éthique à l’âge des machines devrait être fondée sur des valeurs positives. Mais il est difficile de s’entendre sur ce qu’est la valeur ! Des philosophes comme Épicure et Jeremy Bentham ne reconnaissent qu’une seule valeur : le bonheur humain. Mais la plupart des autres philosophes et psychologues pensent qu’il existe un grand nombre de « valeurs intrinsèques » telles que la connaissance, la beauté, la santé, la vérité, le pouvoir ou encore l’harmonie, auxquelles il faudrait ajouter des « valeurs extrinsèques », c’est-à-dire instrumentales, qui soutiennent l’atteinte des valeurs intrinsèques. La plus importante de ces valeurs extrinsèques est naturellement le respect de la vie privée.

Pour autant, comme l’ont montré Karl Popper, Martin Heidegger et d’autres philosophes et épistémologistes, la valeur n’existe pas « en soi » si l’homme n’agit pas sur elle. Ainsi, par exemple, pour les transhumanistes, les humains peuvent être perçus comme des systèmes biologiques sous-optimaux en comparaison des machines dotées d’intelligence artificielle ! Ils placent leur idéal dans des machines considérées comme supérieures par rapport aux humains, ce qui, n’en doutons pas, manipulé par certains esprits malins, pourrait avoir des conséquences mortifères pour les sociétés humaines.

En s’appuyant sur les travaux du psychologue Abraham Maslow, l’universitaire Sarah Spiekermann a regroupé les dix-huit valeurs intrinsèques du premier autour de sept seulement[11] :

- deux conditions préalables : le savoir (véritable opinion, compréhension), la liberté (indépendance, libre choix) ;

- cinq besoins de base : les besoins physiologiques (santé et force, vie prospère, activité), les besoins de sûreté (paix, sûreté, sécurité), les besoins d’appartenance et d’amour (véritable amitié, coopération, amour), les besoins d’estime (pouvoir, accomplissement, respect de soi-même, réputation, honneur, reconnaissance sociale), le besoin de réalisation de soi.

Le respect de la vie privée est une valeur extrinsèque qui joue un rôle essentiel dans toutes ces valeurs intrinsèques. Le lien entre « valeurs » et « respect de la vie privée » est ainsi établi. C’est pourquoi il importe d’assurer la protection des valeurs mentionnées ci-avant dans les environnements informatiques actuels et futurs, notamment en ce qui concerne l’intelligence artificielle.

Daniel Solove, un professeur de droit américain à la George Washington University Law School, a proposé en 2006 une intéressante taxonomie du respect de la vie privée en montrant que la plupart des problèmes provenaient des informations générées sur les personnes.

La collecte d’informations soulève deux risques par rapport au respect de la vie privée :

- la surveillance, qui consiste à épier, écouter ou enregistrer de façon clandestine les diverses activités d’une personne ;

- l’interrogation, qui consiste à exercer des pressions sur une personne pleinement consciente afin de l’amener à divulguer des informations sur elle.

Le traitement des informations soulève d’autres risques :

- l’agrégation de divers éléments d’information au sujet d’une personne ;

- l’identification d’une personne à partir de diverses informations reliées à elle ;

- l’insécurité, qui résulte de la négligence en ce qui concerne la protection d’informations stockées, ce qui peut conduire à de possibles fuites ou à des accès non autorisés ;

- l’usage secondaire d’informations stockées qui, sans le consentement d’une personne, sont détournées de leur objet initial.

En se référant plus ou moins explicitement à ces valeurs – intrinsèques et extrinsèques – les débats sur l’éthique sont aujourd’hui étroitement liés à deux grandes révolutions qui se déploient parallèlement à une allure de plus en plus vive.

Premièrement, la machine intelligente, c’est-à-dire essentiellement les robots et les systèmes autonomes, auxquels il convient d’ajouter les objets connectés (ou encore l’Internet des objets). Elle est portée par une double révolution, celle de l’intelligence artificielle qui permet à l’homme de créer une « intelligence non-biologique » supérieure à l’intelligence humaine et celle des nanotechnologies qui lui permet de manipuler la matière aux niveaux moléculaire et atomique. Les machines du futur seront ainsi dotées de capacités sans précédent : elles pourront réunir les ressources bien au-delà de ce dont l’homme est capable ; elles possèderont des mémoires superpuissantes ; et elles pourront fonctionner vingt-quatre heures sur vingt-quatre, de façon connectée à travers le monde, en combinant les meilleures compétences sans jamais quitter le niveau de performances maximum. Se pose ici la question centrale du rapport de l’humain à la machine. De quelle façon l’humain pourrait-il garder la maîtrise de ce que fera la machine ?

La réponse se trouve peut-être dans l’« humain augmenté », seconde grande révolution de notre époque. L’humain augmenté, c’est celui dont les différentes dimensions, notamment physiques et cognitives, se trouvent « améliorées » par les nouvelles technologies évoluant à la confluence des nanotechnologies, des biotechnologies, des technologies de l’information et des sciences cognitives (NBIC). L’idée n’est pas nouvelle, mais elle fut présentée de manière détaillée et cohérente en 2002 dans un rapport visionnaire de la National Science Foundation (NSF) et du département du Commerce (DOC) américains. L’homme augmenté serait le seul capable de concurrencer les capacités grandissantes des machines et d’une future intelligence artificielle générale. La convergence NBIC se trouve aujourd’hui enrichie par une autre révolution, celle de la génétique qui permet à l’homme de reprogrammer sa propre biologie. Ainsi, l’homme-machine, post-humain, ou encore trans-humain, est celui qui, en détenant les codes de sa propre fabrication, sera capable d’en modifier la structure, de la doter de superpouvoirs qui l’affranchissent des limites physiques, biologiques et cognitives auxquelles l’humanité demeure soumise jusqu’à présent. L’humain augmenté laisse entrevoir la réalisation du rêve d’une extrême longévité, d’une force, une résistance et une intelligence accrues, d’une liberté du corps retrouvée. L’esquisse d’une telle amélioration des performances a fait l’objet en France d’une forte reconnaissance dans les médias lorsqu’en 2019 un jeune tétraplégique réussit à contrôler son exosquelette grâce à des électrodes implantées dans son crâne[12]. Cette révolution comporte des promesses indéniables, mais elle soulève également des questions fondamentales pour « l’avenir du futur » de l’humain[13]. L’humain augmenté devra-t-il à un moment donné s’en remettre à d’autres acteurs afin que son « augmentation » soit activée, modifiée ou maintenue en état de fonctionnement ? Dans ce cas, ces acteurs pourront-ils prendre connaissance des données personnelles des individus, voire piloter ceux-ci à distance ? Quels risques y auraient-ils que les humains augmentés passent sous le contrôle de personnes malveillantes ? Quel pourrait être l’impact de cet humain augmenté sur la société elle-même, par exemple comment évolueront les relations humaines, en termes d’interactions affectives et de solidarités, et les relations sociales, en termes d’accès non discriminatoire au travail ?

Se pose également la question de savoir comment s’exercera la cohabitation entre, d’une part, l’humain augmenté, doté de capacités extraordinaires mais aussi incité par la réglementation ou par des « manipulations douces » (nudge) à régler ses comportements sur des normes et des codes, et, d’autre part, les machines intelligentes, vouées peut-être bientôt à posséder leur propre « conscience ». Nous pourrions avoir d’un côté des sujets transformés en quasi-objets en raison de leur obligation de se conformer à des comportements jugés « normaux » et, de l’autre, des objets transformés en quasi-sujets grâce à des intelligences artificielles autonomes et auto-apprenantes capables de prendre des décisions sans contrôle humain. Il serait très intéressant que les scientifiques et les philosophes se penchent sur ces questions, les premiers pour comprendre les transformations profondes que ces évolutions vont entraîner sur le cerveau et le comportement biologique de l’humain, les seconds pour réfléchir aux contours de ses nouvelles relations au monde qui l’entoure.

Les auteurs du vingtième siècle avaient entrepris de caractériser les figures humaines de l’Histoire, passant en revue le Saint, le Héros, le Chevalier, le Sage, et enfin l’honnête homme du dix-septième siècle. Paraphrasant Saint-Augustin, le philosophe français Emmanuel Mounier s’était demandé, non sans cynisme, si le vingtième siècle n’avait pas accouché du médiocre satisfait. Fi de tout cela. N’est-ce pas dorénavant l’homme hyperconnecté qui devient la nouvelle figure autour de laquelle la société est en train de se réorganiser ?

Les psychologues nous alertent cependant sur le fait que les sociabilités virtuelles n’ont qu’une portée relative : les « amis virtuels » sont bien éloignés du modèle de Montaigne et La Boétie, les échanges sur les forums n’effacent pas vraiment l’impression d’être étranger aux autres, le sentiment de solitude ou d’isolement ne disparaît pas, au contraire ! S’ensuit de nouvelles pathologies telles que la fatigue chronique, l’addiction digitale, la perte de concentration, le burnout. Par conséquent, la prolifération des interactions sociales constitue au mieux un palliatif au sentiment d’abandon et de perte de contrôle de leurs existences de la majorité des êtres humains. En outre, cet humain hyperconnecté n’est-il pas devenu avant tout un consommateur augmenté, profilé grâce aux traces qu’il laisse sur les sites web et sur les réseaux sociaux, lesquelles permettent de l’inciter à consommer plus ? Le risque est également qu’il perde le contrôle de son esprit critique, enfermé dans une bulle informationnelle qui le rend vulnérable à des formes de manipulation intellectuelle et politique. Jusqu’où doit-on accepter de laisser les technologies conçues et mises en œuvre par un nombre restreint de sociétés technologiques géantes (« big tech »), de plus en plus dominatrices, pour le moment basées aux États-Unis et en Chine, lire dans nos pensées, décrypter nos émotions, deviner nos besoins et nos désirs, décider de la façon dont le contenu de nos pensées sera protégé ?

Les principes éthiques en intelligence artificielle

En faisant un peu d’humour l’on pourrait dire que définir des principes éthiques pour l’intelligence artificielle est chose aisée : quasiment tous les pays et tous les types d’organisations ne l’ont-ils pas fait ? Plus que pour d’autres technologies numériques disruptives, comme l’internet des objets ou la 5G, les valeurs et les principes susceptibles de guider le développement et le déploiement de l’intelligence artificielle dans l’économie et la société mobilisent l’intérêt, l’engagement et la participation de tous les acteurs de tous les continents. Les livres, articles, rapports, « déclarations » et autres documents écrits ne manquent pas en la matière, et l’océan des contributions, outre qu’il souligne l’attractivité du sujet, et en filigrane les inquiétudes qu’il génère, n’a cessé de s’agrandir depuis l’année 2017.

Afin de resserrer le cadre d’analyse, nous avons choisi d’évoquer ici sept sources d’informations dont la dernière, celle de la Commission européenne, sera détaillée dans la section suivante :

- Les 23 principes d’Asilomar pour un développement éthique de l’intelligence artificielle[14]

- La Déclaration de Montréal pour un développement responsable de l’intelligence artificielle[15]

- Les principes généraux définis dans l’initiative globale de l’IEEE[16]

- Les cinq principes composant le « code IA » de la Chambre des Lords britannique[17]

- Les travaux du Partenariat sur l’intelligence artificielle, un organisme multipartite comprenant des universitaires, des chercheurs, des organisations de la société civile et des entreprises qui contribuent au développement et à l’utilisation de l’intelligence artificielle[18]

- Le cadre éthique fourni par AI4People[19], qui s’appuie sur les quatre principes fondamentaux de la bioéthique (bienfaisance, non-malfaisance, autonomie et respect de l’autonomie, justice) et en ajoute un nouveau : l’explicabilité, qui comprend l’intelligibilité et la responsabilité.

La bonne nouvelle est que si l’on passe au crible les différents principes fournis dans les documents précédents – une cinquantaine au total – l’on constate une forte cohérence entre eux et par conséquent il est possible de les regrouper en quelques grandes catégories. C’est ce que la Commission européenne a su faire faire, et c’est pourquoi nous nous appuierons largement sur les résultats de ses travaux.

Précisons déjà que les valeurs et principes éthiques concernant l’intelligence artificielle (nous aurions pu aussi évoquer l’internet des objets ou la 5G) offrent une base robuste pour examiner plus loin le cas particulier des applications mobiles pour la recherche de contacts dans le contexte de la pandémie de la Covid-19, tout en gardant à l’esprit que chaque cas particulier soulève des interrogations spécifiques qu’il faut savoir reconnaître et prendre en compte.

L’Europe en pointe des réflexions sur l’éthique

L’Union Européenne assume un rôle de leadership planétaire dans la réflexion sur une « intelligence artificielle digne de confiance »[20]. En avril 2019, le groupe d’experts de haut niveau (AI HLEG) que la Commission européenne avait mis en place en juin de l’année précédente publia ses lignes directrices sur l’éthique en matière d’intelligence artificielle. Selon les experts européens, l’aboutissement à une intelligence artificielle digne de confiance requiert sept principes :

Le 17 juillet 2020, le AI HLEG a présenté la liste finale d’évaluation destinée à favoriser une intelligence artificielle digne de confiance (ALTAI)[21]. Cette liste d’évaluation accessible et dynamique doit permettre aux développeurs et aux déployeurs dans les entreprises et autres organisations d’autoévaluer la fiabilité de leurs systèmes d’intelligence artificielle (IA) en cours de développement.

Les travaux du AI HLEG, qui s’inscrivent dans une stratégie globale sur l’intelligence artificielle[22], seront bientôt complétés par de nouveaux projets de recherche et d’innovation (R&I), à savoir ceux qui seront développés dans le programme Horizon Europe 2021-2027[23].

Il faut souligner l’engagement de l’Union Européenne, aiguillonnée par la Commission européenne, sur le thème de l’éthique, non seulement en ce qui concerne l’intelligence artificielle, mais également pour d’autres sujets, tels que la recherche biomédicale, les sciences de la nature et les humanités. La Charte des droits fondamentaux de l’Union Européenne et la Convention européenne sur les droits humains constituent les principaux repères de la Commission européenne. Il s’ensuit que les questions abordées le plus fréquemment sont les suivantes : l’implication des enfants, des patients et des personnes vulnérables ; l’utilisation des cellules souches embryonnaires humaines ; le respect de la vie privée et la protection des données à caractère personnel ; la mauvaise utilisation ou l’utilisation malveillante ; l’impact sur l’environnement.

En affirmant sa détermination sur l’éthique, l’Union Européenne poursuit la démarche qui avait abouti en 2016 au règlement général sur la protection des données (RGPD). A ce sujet, il convient de relever que le comité européen de la protection des données (CEPD) a publié le 19 mars 2020 une déclaration dans laquelle il affirme que « même dans ces temps exceptionnels, le responsable du traitement des données (« data controller ») et le sous-traitant des données (« data processor ») doivent assurer la protection des données personnelles de la personne concernée (« data subject »). »[24]Cette protection constitue, en effet, une dimension fondamentale du respect de la vie privée des individus et, partant, d’une conduite éthique dans toute application numérique de recherche des contacts.

Ethique et algorithmes : peuvent-ils converger ?

Les « valeurs » qui définissent l’éthique et les sept « principes » qu’en a tirés la Commission européenne en ce qui concerne « une intelligence artificielle digne de confiance » peuvent se heurter aux algorithmes qui, quels qu’ils soient, sont neutres par rapport à eux. Il va falloir encore attendre quelques années avant de savoir si l’intelligence artificielle peut être développée d’une façon éthique. Pour le moment, il faut garder à l’esprit que les algorithmes d’intelligence artificielle sont amoraux, comme c’est le cas par exemple lorsqu’ils commettent des discriminations raciales. Par conséquent, le développement d’une intelligence artificielle éthique ne doit pas être l’affaire seulement des juristes et des régulateurs, mais aussi celle des scientifiques[25]. Ces derniers savent bien que l’intelligence artificielle est une « boîte noire » : l’ordinateur est capable de distinguer un chat d’un chien, mais nul ne sait précisément comment il est parvenu à la bonne conclusion ! Pour obtenir une intelligence artificielle éthique, il est indispensable de comprendre pourquoi les algorithmes font des erreurs ; c’est ainsi que s’est constitué récemment un nouveau domaine de la recherche en intelligence artificielle, la « quantification de l’incertitude », dont le but est d’aider à développer une façon claire et exacte de communiquer la marge d’erreur d’un algorithme.

Cependant, tous les défis éthiques ne pourront pas être relevés avec des solutions seulement techniques. Comme nous l’avons vu lorsque nous avons évoqué plus haut le sujet des « valeurs », les dilemmes éthiques, par nature, sont subjectifs et, par conséquent, requièrent des individus qu’ils résolvent entre eux leurs priorités conflictuelles. L’exemple bien connu est celui de la voiture autonome qui, dans l’hypothèse d’un accident inévitable en ville, devrait « choisir » entre faire une embardée pour épargner la vie de ses trois passagers, parmi lesquels se trouve un enfant, ou causer la mort de quatre piétons âgés. Selon leurs cultures, les individus qui sont interrogés sur ce dilemme répondent différemment : en Chine et au Japon, pays où les cultures attachent un poids plus grand à la collectivité, la probabilité de sacrifier les piétons est moins forte qu’ailleurs où les cultures accordent plus d’importance à l’individu. Ce cas poussé à son extrémité soulève une question à laquelle les mathématiques et les avancées techniques ne peuvent pas répondre : si j’achète une voiture autonome qui a été programmée en France et que je la conduise en Asie, à quelle éthique devrait-elle se soumettre ?

La conclusion qu’il faut tirer de cette analyse est que le développement d’une intelligence artificielle digne de confiance requiert l’engagement et la participation de tous les acteurs : experts de toutes disciplines, spécialistes des sciences sociales, éthicistes. C’est pourquoi la Commission européenne devra veiller à ce qu’au cours des prochaines années le AI HLEG poursuive ses travaux de conserve avec les scientifiques, ingénieurs et autres participants dans les futurs projets de R&I Horizon Europe.

Le traçage des contacts dans le cas de la Covid-19 : les enjeux éthiques entre l’urgence sanitaire et une mosaïque de solutions

Une épidémie de pneumonies d’allure virale d’étiologie inconnue a émergé dans la ville de Wuhan (province de Hubei, Chine) en décembre 2019. Le 9 janvier 2020, la découverte d’un nouveau coronavirus (appelé 2019-nCoV, puis SARS-CoV-2) a été annoncée officiellement par les autorités sanitaires chinoises et l’Organisation mondiale de la santé (OMS). Ce coronavirus est l’agent responsable de la nouvelle maladie infectieuse respiratoire appelée Covid-19 (pour CoronaVIrus Disease). Le SARS-Cov-2 se transmet d’individu à individu par voie aérienne de façon à former une chaîne de contaminations : une personne infectée transmet le virus à un autre individu qui contamine à son tour un autre individu, etc. La lutte contre la diffusion du coronavirus concerne donc l’identification et la rupture des chaînes de contaminations.

Afin de soutenir cette rupture, des solutions numériques de recherche des personnes infectées et d’identification des individus avec lesquels elles ont été en contact rapproché et prolongé ont été développées dès les premières semaines de diffusion du nouveau coronavirus. D’abord utilisées en Asie, notamment à Singapour (Trace Together) et en Chine (Close Contact Detector), les solutions de recherche de contacts ont ensuite été développées dans les pays occidentaux où elles ont généré des débats souvent houleux concernant leur efficacité et le respect de la vie privée des individus (non-respect du secret médical ou de la vie privée des personnes, limitation des libertés individuelles).

A peu près tout le monde est d’accord pour dire que l’outil numérique doit être intégré à un système plus large. Pour que l’épidémie s’éteigne, il ne suffit pas que les individus utilisent une application sur leur téléphone portable ; il faut aussi faire intervenir des personnes sur le terrain afin de mener le travail d’investigation (contact tracers).

Les solutions numériques de recherche de contacts : une mise en place difficile

« Une nouvelle application de traçage Covid est lancée en Angleterre et au Pays de Galles » (source : Financial Times, 24/09/2020), « Comment Jean Castex a tué StopCovid en une phrase » (source : Le Figaro 25/07/2020). Neuf mois après la découverte du coronavirus, sept mois après le moment où il ne fit plus aucun doute que le nouveau virus entraînerait une pandémie, les deux titres de la presse précédents montrent à quel point les pouvoirs publics ont eu du mal à mettre en place des applications de traçage des contacts indépendantes. Le Royaume-Uni et la France furent les deux principaux pays à rejeter l’offre initiale d’assistance technique d’Apple et Google tandis que les deux sociétés « big tech » collaboraient au même moment avec les autorités médicales de plusieurs autres pays européens, notamment l’Allemagne et l’Italie, en vue d’introduire une technologie de traçage des contacts dans leurs réseaux mobiles.

La chronologie des événements au Royaume-Uni dévoile des leçons intéressantes :

- 31 janvier : confirmation des deux premiers cas de coronavirus ; le service national de santé (National Health Service ou NHS) annonce qu’il va traquer tous les contacts de ces patients ;

- 29 février : 23 cas sont confirmés et plus de 10.000 personnes ont été testées en un mois ;

- 12 mars : la phase d’« endiguement » de l’épidémie est remplacée par une phase de « retardement » : désormais, les efforts ne portent plus sur la recherche des contacts des patients connus mais se concentrent sur la réduction de la pointe des infections pour faire en sorte que les patients les plus malades puissent recevoir les soins dont ils ont besoin (stratégie dite de l’aplatissement de la courbe) ;

- 23 mars : le Premier Ministre ordonne aux Britanniques de rester chez eux et demande à la police d’imposer cette décision de confinement national ;

- 12 avril : le gouvernement annonce qu’il va développer une application de suivi des contacts ;

- 17 avril : le Royaume-Uni annonce qu’il va reconstruire des équipes de « chercheurs de contacts » dans le cadre d’une nouvelle stratégie de test et de traçage ;

- 5 mai : le NHS lance une application de recherche des contacts qui s’inscrit dans la stratégie « Tester, Suivre et Tracer » visant à traquer et isoler le virus afin de l’empêcher de se reproduire ; l’application utilise les signaux Bluetooth pour dresser une cartographie des contacts entre les utilisateurs et alerter ceux qui se sont trouvés proches d’une personne infectée ;

- 8 mai : en réponse aux critiques sévères qui ont suivi la première annonce, émanant notamment des défenseurs du respect de la vie privée, préoccupés du fait que les données anonymisées seront stockées dans une base de données centrale, le NHS annonce qu’il travaille déjà à l’élaboration d’une seconde version de l’application incorporant la technologie fournie par Google et Apple ;

- 28 mai : suite à la décision annoncée le 17 avril, la recherche manuelle des contacts reprend grâce au recrutement et à la formation de 25.000 personnes vouées à cette mission ;

- 18 juin : le Royaume-Uni fait volte-face en abandonnant la technologie développée par ses services sanitaires au profit de celle d’Apple et Google ; lors de la phase pilote menée sur l’Île de Wight, l’application centralisée n’avait reconnu que 4% des téléphones mobiles d’Apple et 75% des appareils Android de Google ;

- 13 août : des essais sont annoncés concernant une nouvelle application fondée sur un modèle décentralisé ;

- 24 septembre : le NHS lance la nouvelle application – appelée NHS Covid-19 – qui rencontre aussitôt un succès estimable (un million de téléchargements le premier jour).

En conclusion, il aura fallu cinq mois au Royaume-Uni pour combler l’écart entre la décision de rechercher les contacts à l’aide d’une technologie numérique (avril) et le lancement effectif de l’application (septembre). Dans un contexte tendu où les pouvoirs publics ont dû faire front à une menace sanitaire survenue brutalement, d’origine incertaine, au déroulement imprévisible, il fallut mettre en place un arsenal de mesures d’urgence parmi lesquelles, en l’absence de traitements et d’un vaccin, la recherche de contacts apparaissait comme indispensable. Cette recherche devait s’effectuer de façon classique avec des équipes formées de manière appropriée, mais aussi grâce au développement d’applications numériques basées sur les technologies performantes et omniprésentes dont l’humanité dispose à notre époque.

La France s’est trouvée dans une situation similaire à celle du Royaume-Uni, mais il semble que l’objectif d’indépendance technologique vis-à-vis des GAFA, en l’occurrence de Google et d’Apple, a pris au moins autant d’importance aux yeux des autorités que celui de respect de la vie privée. Le cas de ce pays et de son application TousAntiCovid sera examiné en détail plus loin. Retenons simplement qu’à la fin du mois de septembre 2020 l’application française, lancée quatre mois plus tôt, le 2 juin, n’avait été téléchargée qu’environ 3 millions de fois, tandis que l’application allemande, lancée le 16 juin, l’avait été 18 millions de fois et l’application britannique 12,4 millions de fois en seulement quatre jours [26]

Au-delà des péripéties techniques, réglementaires et sociétales de l’année 2020, nul doute que si la pandémie perdure la nécessité de recourir à la technologie pour rechercher les contacts de personnes contaminées ou qui ont été identifiées comme ayant croisé des personnes contaminées sera plus grande que jamais. Moins d’un an après le début de la pandémie, le développement des applications de recherche de contacts se poursuit à travers le monde mais toutefois de façon inégale. Dans la plupart des pays, notamment en Europe, les débats s’enflamment autour de l’équilibre à trouver entre le respect de la vie privée et l’efficacité. En conséquence, le déploiement des applications est freiné, voire dans certains pays comme le Royaume-Uni stoppé puis repris sous d’autres formes. De leur côté, les États-Unis ont adopté une approche décousue dans la mesure où les états sont autorisés à construire leurs propres applications. Quoi qu’il en soit de la stratégie suivie par les différents pays, ce qui est sûr est qu’il faudra atteindre des niveaux élevés d’adoption des applications numériques de recherche de contacts pour que l’effort en vaille la peine en termes d’efficacité.

Le respect de la vie privée constitue un défi majeur pour l’avenir des solutions numériques de suivi des contacts. Un système utilisé par des dizaines de millions d’individus qui manipulent des données aussi sensibles qu’un historique de contact, voire des données médicales, nécessite un très haut niveau de sécurité. En Allemagne, le Chaos Computer Club (CCC), association d’experts en informatique qui conseille depuis trente ans le gouvernement fédéral sur les questions de vie privée, a contribué utilement au débat sur l’éthique en fournissant une liste de dix critères restrictifs pour que ce type de solutions puissent tirer parti du potentiel épidémiologique du suivi de contacts sans pour autant constituer une menace en matière de vie privée[27].

Il est intéressant en passant de comparer les critères éthiques des experts de la Commission européenne (AI HLEG) et ceux du CCC. Les premiers sont plus larges puisqu’ils s’appliquent à l’intelligence artificielle, d’où des notions comme « facteur humain » ou « bien-être sociétal », mais ils correspondent dans une large mesure, avec un langage un peu différent, à ceux du CCC, même si ces derniers placent le curseur sur des points spécifiques tels que le « but épidémiologique », la « géolocalisation » ou encore la « non-observabilité des communications ». Cela montre bien qu’au-delà des « valeurs », les principes éthiques doivent être modulés en fonction des exigences de chaque domaine particulier, en fonction de sa taille et de ses spécificités.

La recherche de contacts par voie numérique : approche centralisée ou approche décentralisée ?

Le développement de solutions numériques de recherche des contacts soulève un ensemble de questions fondamentales avant même de s’intéresser aux enjeux éthiques :

- Qui a commandité l’application et qui l’a développée ?

- Quelles sont ses fonctionnalités ?

- Quand a-t-elle été lancée ?

- Quelles technologies utilise-t-elle ?

- Où est-elle disponible et sur quelles plates-formes ?

- Quel niveau de pénétration a-t-elle réalisé au bout d’une journée/semaine ou d’un mois ?

Cet article ne développera pas ces différents points. Toutefois, il faut souligner l’importance du choix de la technologie de base destinée à rechercher et identifier les contacts :

Dans le monde, et notamment en Europe, la plupart des pays ont choisi les « poignées de main » Bluetooth à courte portée entre les appareils mobiles comme le meilleur moyen d’enregistrer un contact potentiel, même s’il ne fournit pas de données de localisation.

La technologie Bluetooth, invoquée dans toutes les applications de suivi de contacts, n’a pas été conçue pour mesurer une distance, mais seulement pour transmettre des données. Or, l’intensité du signal reçu d’un émetteur dépend de la distance. Les chercheurs doivent prendre en compte les différents modèles de téléphones, dont les capacités en matière de Bluetooth varient, mais aussi les innombrables situations de la vie quotidienne qui induisent une cascade de facteurs parasites et inconnus a priori, comme la puissance de transmission (que le consortium Apple-Google s’efforce de préciser) ainsi que l’atténuation du signal dans sa propagation dans le milieu (par exemple selon que l’appareil soit à l’air libre, dans un environnement densément peuplé ou non, dans un sac à dos, dans une poche de vêtement). Par conséquent, la capacité de la technologie Bluetooth à atteindre le niveau de précision nécessaire reste la grande inconnue de l’équation. Il n’est pas certain que les paramètres de proximité des applications de suivi des contacts qui sont déployées dans de nombreux pays correspondent toujours aux conditions de contamination telles qu’elles sont comprises aujourd’hui. Des études ont montré, en effet, que le virus pouvait être transmis par effet aérosol, donc par voie aérienne[29]. La proximité doit certainement jouer un rôle majeur dans la transmission, mais également d’autres paramètres, tels que la nature de l’espace dans lequel on se trouve (intérieur ou extérieur), les conditions d’aération, la charge virale des aérosols.

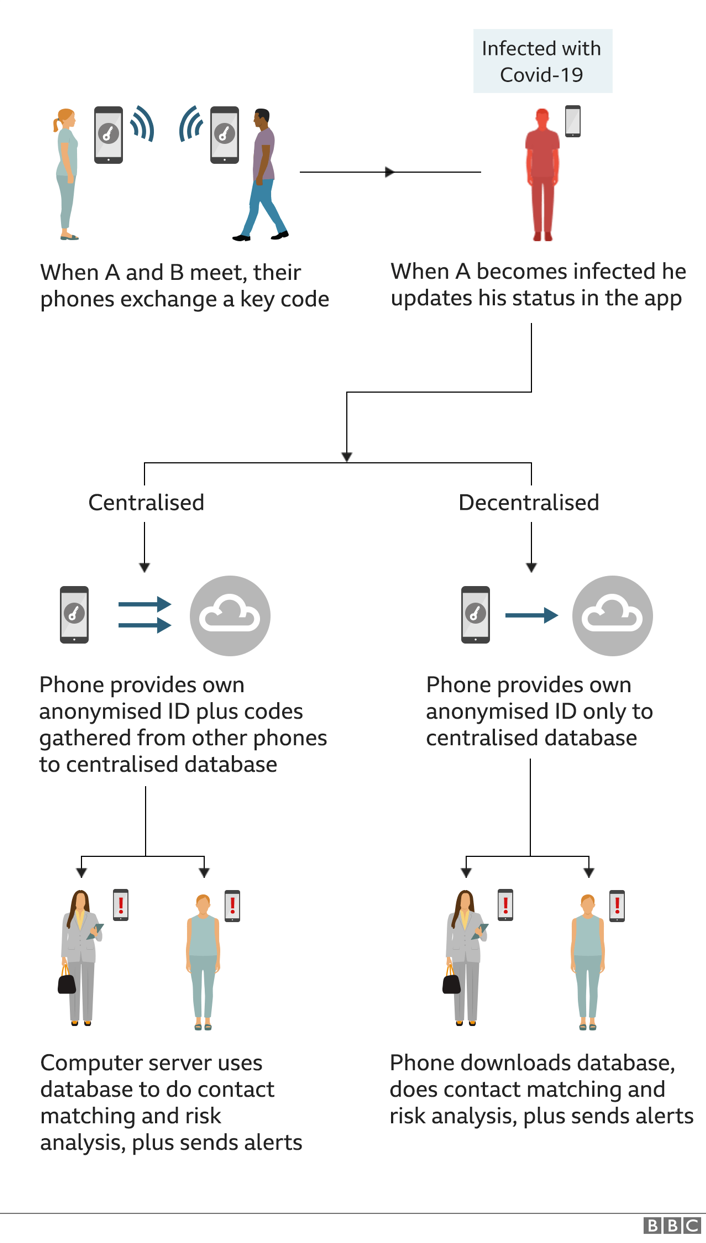

Si la technologie Bluetooth est privilégiée par la grande majorité des pays, en revanche ces derniers ne sont pas d’accord sur l’opportunité de consigner les contacts sur des appareils individuels (approche dite « décentralisée ») ou sur un serveur central (approche dite « centralisée »). La question sensible est en effet de savoir où se prend la décision de déclencher l’envoi des notifications aux contacts d’une personne qui vient d’être diagnostiquée positive au Covid-19. Est-ce sur un serveur contrôlé par une autorité sanitaire de confiance ou bien sur le téléphone lui-même ?[30]

L’approche centralisée est théoriquement plus efficace que sa concurrente ; elle permet en effet aux équipes de recherche de contacts existantes de travailler directement sur les téléphones et de retrouver facilement pour les avertir les individus qui peuvent être à risque. Dans le cadre de l’approche décentralisée, les utilisateurs peuvent donner leur consentement pour partager leur numéro de téléphone ou les détails de leurs symptômes, ce qui permet alors aux autorités sanitaires de prendre contact avec eux et de donner des conseils sur la meilleure marche à suivre en cas de risque avéré. Ce consentement est cependant donné dans l’application et ne fait pas partie de l’architecture centrale du système.

Les modèles centralisé et décentralisé de suivi des contacts

Source: BBC News, Coronavirus: The great contact-tracing apps mystery, 21/07/2020

L’Union Européenne a montré qu’elle était en pointe sur les enjeux éthiques des technologies numériques, notamment l’intelligence artificielle. Toutefois, la question de la sécurité de l’échange d’informations entre les applications nationales de traçage des contacts reposant sur une architecture décentralisée s’est posée avec acuité. Rappelons qu’au départ les États membres s’étaient lancés dans des initiatives purement nationales dont la plupart, après valse-hésitation, convergèrent vers l’approche décentralisée proposée par l’alliance Google/Apple. Dès lors se posa la question de l’interopérabilité entre les différentes applications nationales. Comme l’indiqua Thierry Breton, commissaire au marché intérieur, « De nombreux États membres ont mis en œuvre des applications nationales de traçage des contacts et d’alerte. Il est temps à présent de faire en sorte que ces applications puissent communiquer entre elles. Les déplacements et les échanges personnels sont au cœur du projet européen et du marché unique. » Dès le 14 septembre 2020, la Commission européenne put annoncer la mise en place d’un service-passerelle d’interopérabilité permettant de connecter les applications nationales à travers l’Union Européenne et, par conséquent, de contribuer à briser la chaîne des infections dues au coronavirus et à sauver des vies. Un mois plus tard, le 19 octobre, ce service-passerelle a commencé à fonctionner, permettant à trois premières applications nationales, celles de l’Allemagne, de l’Italie et de l’Irlande, d’être reliées au système[31].

L’interopérabilité en Europe : comment ça fonctionne ?

L’entrée en service de la passerelle d’interopérabilité met en évidence un certain isolement de la France dans l’Union Européenne. Un pays – la Suède – a certes décidé de ne pas développer d’application de suivi des contacts, d’autres l’envisagent mais ne se sont pas encore lancés, mais le fait important est que la plupart des pays ont mis en place une application en optant, après parfois quelques atermoiements, pour une approche décentralisée soutenue par Google et Apple.

Comment prendre en compte les enjeux éthiques dans les applications de suivi des contacts ?

Dès le début de la pandémie furent développées des solutions de tracking des individus afin de contrôler le respect des confinements et des quarantaines décidés par les gouvernements. Il s’agissait d’une démarche logique, nécessaire, et assez simple à mettre en place à la condition que les équipes de « traceurs » existassent pour exécuter le travail. Puis assez rapidement l’idée germa parmi de nombreux gouvernements de compléter les solutions de tracking par des solutions de tracing des individus, cette fois pour identifier et rompre les chaînes de transmission de la Covid-19. C’est ainsi que des solutions et applications mobiles furent lancées à travers le monde, tout d’abord en Asie puis après quelques semaines en Europe et ailleurs.

Nous avons vu que les gouvernements pouvaient adopter des protocoles techniques différents (Google/Apple, DP3T etc.) ainsi que des technologies différentes pour la collecte des données (Bluetooth, géolocalisation).

Si le choix de la technologie s’est porté largement sur Bluetooth, c’est parce qu’en dépit des incertitudes concernant le niveau de précision des transmissions, les garanties en termes de respect de la vie privée sont les meilleures.

Dans la première partie, nous avons montré que l’éthique portait sur des valeurs et que ces valeurs pouvaient être respectées en suivant un certain nombre de principes, parmi lesquels ceux préconisés par le groupe d’experts de la Commission européenne (AI HLEG) font la quasi-unanimité. Ces principes doivent être ensuite transformés en des questions à la fois simples et claires afin qu’ils puissent être appliqués dans des cas particuliers, comme celui du suivi des contacts. Ces questions doivent au minimum être les suivantes :

- Le téléchargement et l’utilisation de l’application sont-ils volontaires (opt-in) ou bien obligatoire ?

- Existe-t-il des limites à l’utilisation des données ?

- Les données sont-elles destinées à être détruites au bout d’un certain temps ?

- La collecte de données est-elle minimisée ?

- La stratégie sous-jacente est-elle transparente ?

- Les enfants, les personnes âgées et les personnes handicapées peuvent-elles avoir accès à l’application ? Si oui, comment, et comment leurs données sont-elles traitées ?

Les deux points fondamentaux lorsqu’on s’intéresse au respect de la vie privée dans le cas des applications mobiles destinées à la recherche des contacts sont, d’une part, l’identité des utilisateurs (les connexions via Bluetooth permettent de mettre en œuvre une approche fondée sur l’anonymisation ou la pseudonymisation, tandis que celles par géolocalisation ne respectent pas la vie privée) et, d’autre part, la structure et le stockage des données (modèle centralisé ou décentralisé).

Il n’est pas surprenant que la façon de traiter le respect de la vie privée diffère grandement entre les pays. A Singapour, l’application « Trace Together » utilise la technologie Bluetooth pour repérer et identifier les personnes qui ont été en contact étroit et prolongé avec d’autres utilisateurs de smartphone testés positivement au Covid-19 ou à haut risque d’être porteurs du virus ; elle alerte alors ces personnes. En cas de suspicion d’une interaction entre un cas confirmé et un individu, le téléchargement de ces données vers un serveur devient obligatoire.

En Chine, où la place accordée à l’individu dans la société est soumise à l’intérêt de la collectivité, la recherche des contacts se fait via la plate-forme « Close Contact Detector » qui a été développée par China Electronics Technology Group Corporation (CETC), propriété de l’État chinois. Cette plate-forme dont l’objet est de signaler aux personnes qu’elles ont été en contact étroite avec des individus infectés a été intégrée à des applications populaires préexistantes, comme Alipay, Wechat et QQ. Elle peut être utilisée par les autorités, les entreprises, les écoles, des employés d’espaces publics ou des représentants de quartiers résidentiels. Les utilisateurs de la plate-forme peuvent y accéder en scannant un code QR et s’inscrire avec un numéro de téléphone en fournissant leur nom et leur numéro d’identification national. Chaque compte associé à un numéro de téléphone peut demander des renseignements sur trois personnes au maximum.

En Allemagne, l’application « Corona-Warn-App » commandée par le gouvernement à SAP et T-Systems, développée par Google et Apple, et inspirée par les travaux du consortium européen DP3T, analyse les signaux Bluetooth émis par les téléphones mobiles afin de détecter les utilisateurs ayant été en contact rapprochés les uns avec les autres. Les individus qui ont été en contact avec une personne infectée sont alors prévenus. Les identités des utilisateurs ne sont pas divulguées, les données sont cryptées et supprimées au bout de quatorze jours.

Au Royaume-Uni, où comme nous l’avons vu la mise en œuvre de l’application NHS Covid-19 a suscité de vifs débats, certains n’hésitent pas aujourd’hui à proclamer que le point d’équilibre entre respect de la vie privée et efficacité privilégie de façon excessive le premier aux dépens de la seconde : l’application permet en effet d’obtenir des détails sur le nombre de tests positifs qui ont été enregistrés et sur le nombre d’alertes qui ont été envoyées aux utilisateurs afin qu’ils s’isolent, mais en revanche elle n’apprend rien sur l’identité de ceux qui ont été testés positivement ni de ceux qui ont été à la source de leur contamination[32]. En d’autres termes, les choix effectués par le gouvernement se sont révélés être plus conservateurs que ceux concernant l’API Apple-Google. Par exemple, les utilisateurs auraient pu se voir demander lorsqu’ils téléchargent l’application s’ils consentaient à fournir un numéro de téléphone afin qu’ils puissent être contactés au moment de leur isolement. Au lieu de cela, ils reçoivent seulement une alerte dont ils peuvent suivre les instructions ou pas.

On le voit, le débat n’est pas clos, ni au Royaume-Uni ni ailleurs dans le monde occidental où les comparaisons que certains tentent de faire parfois avec des pays asiatiques comme le Viêt-Nam ou Taïwan ne sont pas forcément pertinentes.

La question du « contrôle » est évidemment essentielle. Certains gouvernements, comme en France, ont voulu garder le contrôle des données et, par conséquent, ont adopté un modèle centralisé. Mais la plupart, après des débuts erratiques, comme en Allemagne ou au Royaume-Uni, se sont résignés à s’en remettre à Google et Apple. Il est assez curieux de noter que les deux firmes américaines de l’Internet sont en fin de compte perçues comme offrant une solution plus fiable et garantissant davantage la sécurité et le respect de la vie privée grâce à l’anonymisation et à une architecture décentralisée. L’intérêt de Google et d’Apple est évident : plutôt que de se trouver en concurrence avec des gouvernements, ces sociétés préfèrent intelligemment offrir à chaque pays la possibilité d’accéder à leurs interfaces de programmation d’application (API), quitte ensuite pour les pays intéressés de configurer ces interfaces à leur guise, notamment en ce qui concerne les questions de respect de la vie privée. C’est ainsi que le 10 avril 2020 les deux firmes américaines annoncèrent qu’elles travaillaient ensemble au développement d’une application mobile en utilisant les signaux Bluetooth d’un smartphone ; aucune donnée de localisation par GPS ni d’informations personnelles ne seraient enregistrées. « Le respect de la vie privée, la transparence et le consentement sont pour nous de la plus haute importance et nous nous engageons à construire cette fonctionnalité en consultation avec les parties prenantes intéressées », firent savoir Google et Apple dans une déclaration commune.

Les applications mobiles de recherche de contact sont censées établir un compromis, propre à chaque pays en fonction de son histoire, de sa culture et de ses préférences du moment, entre le niveau d’efficacité à attendre pour contrôler la propagation de l’épidémie et le risque potentiel de remise en cause du respect de la vie privée. Des défenseurs des droits fondamentaux craignent que l’outil serve certes dans un premier temps à traquer les contacts des patients nouvellement infectés mais qu’il évolue ensuite vers une situation où il se transformerait en un véritable « passeport d’immunité » devant être présenté systématiquement pour pouvoir utiliser un transport public ou assister à un match de football. En France surtout, le débat demeure intense entre les partisans d’une approche « moderne » pour endiguer l’épidémie de la Covid-19 et les opposants à une telle démarche, qui refusent de souscrire à une approche purement « techniciste » pouvant remettre en cause les droits fondamentaux des individus[33] : « Si les nouvelles technologies sont désormais indispensables à toute politique publique, placer au centre d’une stratégie d’État une application dont l’efficacité est plus que douteuse, et surtout inversement proportionnelle aux risques éthiques, politiques et sanitaires qu’elle comporte, serait catastrophique pour l’évolution de notre société. Les moments d’exception que nous vivons ne doivent pas pousser à composer avec une réponse techniciste, aussi trompeuse que dangereuse, ni nous faire renier nos exigences démocratiques. Ils doivent, au contraire, nous inciter à réaffirmer la part de solidarité et de confiance dont une société a besoin pour continuer de s’inventer sans cesse, en stimulant l’imaginaire social qui la nourrit. »

La solution française : « TousAntiCovid »

La France a développé une application pour aider à la lutte contre le virus Covid-19. Cette application qui s’appelait jusqu’au 22 octobre 2020 StopCovid France, s’appelle désormais TousAntiCovid. La France a fait le choix de ne pas recourir à la géolocalisation, c’est-à-dire au « tracking » qui s’apparente à un suivi des déplacements via les GPS des smartphones et les antennes-relais. TousAntiCovid utilise le « tracing ». Il s’agit de garder en mémoire les contacts entre les personnes via la technologie Bluetooth. Cette technologie est considérée comme efficace et moins intrusive que la géolocalisation. C’est la position du Comité européen à la protection des données selon lequel « l’utilisation des applications de recherche des contacts ne devrait pas reposer sur la recherche de mouvements individuels mais plutôt sur des informations de proximité concernant les utilisateurs. Les applications de recherche de contacts ne nécessitent pas de suivre la localisation des utilisateurs individuels. Les données de proximité devraient plutôt être utilisées » (voir les lignes directrices 04/2020 sur l’utilisation des données de localisation et des outils de recherche des contacts dans le contexte de l’épidémie de Covid-19)[34]. C’est également la position de la Commission européenne qui privilégie les mesures les moins intrusives mais efficaces, notamment l’utilisation de données de proximité, et le fait d’éviter de traiter des données sur la localisation ou les mouvements des personnes (voir la Recommandation (UE) 2020/518 de la Commission du 8 avril 2020 concernant une boîte à outils commune de l’Union en vue de l’utilisation des technologies et des données pour lutter contre la crise de la Covid -19 et sortir de cette crise, notamment en ce qui concerne les applications mobiles et l’utilisation de données de mobilité anonymisées[35]).

Pour procéder à l’analyse éthique de l’application française, nous nous appuierons sur les principes éthiques des experts de la Commission européenne (HLEG)[36] rappelés plus haut. Ces principes sont partagés par la France qui a contribué à leur élaboration et qui nous semblent être à ce jour les plus pertinents pour vérifier si l’application TousAntiCovid est respectueuse des libertés fondamentales et des droits humains dans l’État démocratique qu’est la France.

Comment l’application TousAntiCovid fonctionne-t-elle ?

Comme pour toutes les applications de suivi des contacts, l’application permet aux personnes qui la téléchargent d’être prévenues si elles ont été à proximité, dans un passé proche, de personnes diagnostiquées positives au Covid-19 et disposant de la même application, cette proximité induisant un risque de transmission du virus.

En pratique, une fois installée et les fonctionnalités activées, l’application émet des messages Bluetooth spécifiques et en reçoit qui proviennent d’autres smartphones sur lesquels l’application TousAntiCovid a été installée et activée.

Le dispositif se décompose en une application mobile mise à la disposition sur des équipements mobiles (téléphone mobiles et tablettes) et un serveur central qui assure le stockage et la transmission d’un certain nombre de données. Si un utilisateur a été déclaré positif au Covid-19, il va pouvoir déclarer cet état directement dans l’application non avec son nom mais grâce à un code, le QR code fourni par le laboratoire ou le médecin. L’utilisation de ce code par l’utilisateur lui permet d’envoyer son historique de contacts au serveur central qui traite alors chacun des contacts présents dans l’historique, afin d’en estimer le risque de contamination au virus SARS-CoV-2.

L’application contacte une fois par jour le serveur afin de vérifier le statut d’exposition de l’utilisateur. Les utilisateurs ayant été en contact (à moins d’un mètre pendant au moins 15 minutes) avec la personne diagnostiquée ou dépistée positive sont prévenus par le serveur qu’ils ont été exposés à un risque de contamination au virus SARS-CoV-2 au cours des quinze derniers jours.

Respect de la vie privée et gouvernance des données

Quelle est la finalité du traitement ? Existe-t-il des limites à l’utilisation des données ?

Le but de l’application a été initialement de faciliter la sortie du confinement et de ralentir la propagation du virus. D’après l’article 1 du décret, n° 2020-650 du 29 mai 2020 relatif au traitement de données dénommé « StopCovid France » nouvellement dénommé TousAntiCovid »[37], le traitement a pour finalité : a) l’information d’une personne utilisatrice de l’application du fait qu’elle s’est trouvée à proximité avec un utilisateur de la même application ultérieurement diagnostiquée positif à la Covid-19, de sorte qu’il existe un risque qu’elle soit contaminée à son tour ; b) la sensibilisation sur les symptômes de la maladie, les gestes barrière, l’orientation des contacts à risque vers des acteurs de santé compétents, l’utilisation de données statistiques anonymes au niveau national. La CNIL a préconisé dans son avis du 25 mai que la prise de contact entre l’utilisateur et le professionnel de santé soit recommandée mais laissée à la discrétion de l’utilisateur[38] pour préserver sa liberté individuelle, ce qui a été suivi.

Les opérations suivantes sont expressément exclues des finalités : le recensement des personnes infectées, l’identification des zones dans lesquelles ces personnes se sont déplacées, les prises de contact avec la personne alertée ou encore la surveillance du respect des mesures de confinement ou de toute autre recommandation sanitaire. Le traitement ne doit pas non plus permettre de réaliser le suivi des interactions sociales des personnes.

Ces restrictions dans les finalités écartent en principe le risque que l’application TousAntiCovid ne soit utilisée comme un outil de surveillance de la population ou de coercition, et ce sauf détournement de finalité ou piratage.

Ceci est conforme à la règlementation applicable rappelée dans la recommandation de la Commission européenne selon laquelle : « En ce qui concerne le principe de limitation de la finalité, les finalités doivent être suffisamment précises pour exclure tout traitement ultérieur à des fins non liées à la gestion de la crise sanitaire Covid-19 (par exemple, à des fins commerciales ou répressives) ».

Quelles sont les données traitées et utilisées ? La collecte de données est-elle minimisée ?

Le décret précité liste les catégories de données traitées : la clef d’authentification partagée entre l’application et le serveur central, un identifiant unique associé à chaque application téléchargée généré de façon aléatoire par le serveur central et qui n’est connu que de ce serveur où il est stocké, les codes-pays, les pseudonymes aléatoires et temporaires générés par le serveur, l’historique de proximité, les périodes d’exposition des utilisateurs à des personnes diagnostiquées ou dépistées positives stockées sur le serveur, l’historique de proximité des contacts à risque, le statut « contacts à risque de contamination », la date des dernières interrogations du serveur.

Il n’y a pas de collecte de noms, de numéros de téléphone, ou d’adresses électroniques.

Les données transmises ne le sont que si l’utilisateur de l’application le décide, et ce même s’il est contaminé par le virus de la Covid-19. Il n’a donc aucune obligation de transmission de données et cette transmission n’a aucun caractère automatique.

S’il le décide, l’utilisateur pourra donc transmettre l’historique de proximité des contacts à risque de contamination par le virus de la Covid-19, la date de début des symptômes, et le code QR. Dans un premier temps, l’intégralité de l’historique des contacts de l’utilisateur était envoyée au serveur, si celui-ci décidait d’envoyer ses contacts à risque. Suite à une mise en demeure de la CNIL en date du 20 juillet 2020[39], le système a été modifié et désormais il existe un pré-filtrage de l’historique des contacts de l’utilisateur au niveau du téléphone. Il est donc impossible que l’intégralité de l’historique des contacts de l’utilisateur remonte vers le serveur central, sans pré-filtrage au niveau du téléphone. Seuls les contacts les plus susceptibles d’avoir été exposés au virus sont transmis au serveur central. Le principe de minimisation de la collecte des données est donc respecté.

Cette minimisation de la collecte et de l’utilisation des données est conforme au principe de minimisation du RGPD[40] et rappelé dans les lignes directrices du Comité européen à la protection des données précitées selon lesquelles « dans le contexte d’une application de recherche de contacts, il convient d’accorder une attention particulière au principe de minimisation des données ainsi qu’aux principes de protection des données dès la conception et de protection des données par défaut : i) les applications de recherche de contacts ne nécessitent pas le traçage de la localisation des différents utilisateurs. Il convient plutôt d’utiliser des données de proximité́ ; ii) les applications de recherche de contacts pouvant fonctionner sans identification directe des personnes, il convient de mettre en place des mesures appropriées pour empêcher la ré-identification ; iii) les informations collectées devraient être stockées dans l’équipement terminal de l’utilisateur et seules les informations utiles devraient être collectées en cas d’absolue nécessité. »[41]

Les données sont-elles anonymisées ?

Les données transmises via TousAntiCovid sont très sensibles puisqu’il s’agit de données de santé et qu’elles permettent de créer des historiques des contacts à moins d’un mètre des personnes « croisées » plus de 15 minutes. En l’absence de mesures robustes rendant très difficile la ré-identification des utilisateurs, l’application permettrait de savoir si tel individu a eu le virus, notamment aux personnes avec lesquelles il a été en contact et qui ont téléchargé l’application, et de connaître l’identité de ces personnes, ce qui serait une forte entrave à la vie privée et aux libertés individuelles.

C’est la raison pour laquelle la Commission européenne, dans sa recommandation précitée, indique qu’il convient de respecter l’utilisation de données anonymisées, de mettre en place des garanties afin d’empêcher la désanonymisation et d’éviter la ré-identification des personnes, notamment par le chiffrement. Elle évoque « la mise en place de garanties quant à un niveau suffisant de sécurité des données de l’infrastructure informatique, et une évaluation des risques de ré-identification en cas de mise en corrélation des données anonymisées avec d’autres données ».

Le Comité européen à la protection des données apporte des précisions utiles sur la distinction entre l’anonymisation et la pseudo-anonymisation : pour que l’anonymisation totale soit réelle, il faut qu’elle remplisse trois critères : il ne faut pas que l’on puisse identifier un individu à partir d’un groupe ; il ne faut pas pouvoir relier deux fichiers concernant le même individu ; il ne faut pas pouvoir déduire avec une probabilité significative des informations non connues d’un individu. Le Comité ajoute que seuls des groupes de données (data sets) peuvent être anonymisés, et non une donnée isolée, et par conséquent le fait de crypter une donnée seule ne permet pas son anonymisation mais seulement sa pseudo-anonymisation.

Cette distinction entre l’anonymisation et la pseudo-anonymisation a été rappelée par la CNIL dans un article de synthèse publié sur son site le 19 mai 2020[42], selon lequel « l’anonymisation est un traitement qui consiste à utiliser un ensemble de techniques de manière à rendre impossible, en pratique, toute identification de la personne par quelque moyen que ce soit et de manière irréversible » alors que « la pseudo-anonymisation consiste à remplacer les données directement identifiantes d’un jeu de données (nom, prénom, etc.) par des données indirectement identifiantes ( alias, numéro séquentiel etc.). La pseudo-anonymisation permet donc de remonter à l’identité de la personne concernée, c’est la raison pour laquelle l’utilisation de données pseudo-anonymisées doit respecter la règlementation sur les données personnelles alors que le recours à des données anonymisées est totalement libre.

L’application TousAntiCovid ne garantit pas l’anonymisation des données mais seulement leur pseudo-anonymisation. C’est la raison pour laquelle TousAntiCovid doit respecter le RGPD et la loi informatique et libertés modifiée. Ceci a été rappelé par la CNIL dans son avis du 24 avril 2020[43] selon lequel « il demeure un lien entre les pseudonymes et les applications téléchargées, chaque application étant elle-même installée sur un terminal, qui correspond généralement à une personne physique déterminée ». Le fait que l’application soit téléchargée sur un téléphone mobile doté d’un IMEI (international Mobile Equipment Identity)[44] donne la possibilité de remonter à l’identité de l’utilisateur.

Dans ses lignes directrices, le Comité européen à la protection des données recommande certaines mesures pour les applications de suivi de contacts : des identifiants pseudonymes doivent être échangés entre les mobiles des utilisateurs d’équipement (ordinateurs, tablettes, montres connectées, etc.) ; les identificateurs doivent être générés à l’aide de procédés cryptographiques de pointe ; les identificateurs doivent être renouvelés régulièrement afin de réduire le risque de suivi physique et les attaques de liens ; l’application ne doit pas transmettre aux utilisateurs des informations qui leur permettraient de déduire l’identité ou le diagnostic des autres ; le serveur central ne doit ni identifier les utilisateurs ni déduire des informations à leur sujet.

Qu’en est-il de la pseudo-anonymisation des données personnelles dans TousAntiCovid ? Ces mesures sont-elles respectées ?